【PyTorch】教程:torch.nn.GELU

创始人

2025-05-29 07:17:04

torch.nn.GELU

原型

CLASS torch.nn.GELU(approximate='none')

参数

- approximate (str, optional) – gelu 近似算法用

none或者tanh, 默认为none;

定义

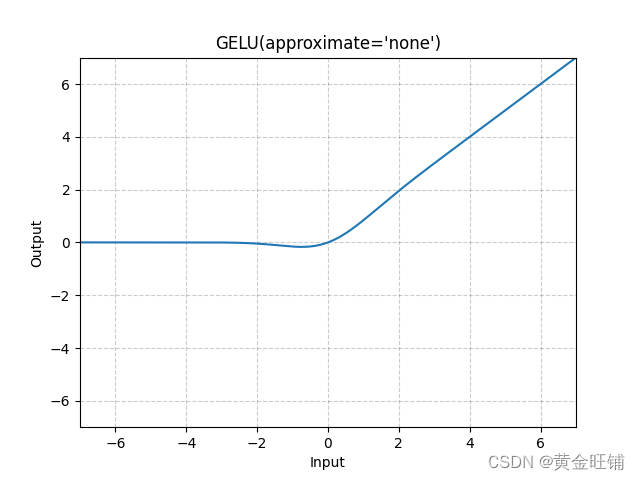

高斯误差线性单元函数

GELU(x)=x∗ϕ(x)\text{GELU}(x) = x * \phi(x) GELU(x)=x∗ϕ(x)

其中 ϕ(x)\phi(x)ϕ(x) 为高斯分布的累积分布函数;

当参数为 tanh, Gelu 估计为

GELU(x)=0.5∗x∗(1+Tanh((2/π)∗(x+0.044715∗x3)))\text{GELU}(x)=0.5∗x∗(1+\text{Tanh}((2/\pi)∗(x+0.044715∗x^3))) GELU(x)=0.5∗x∗(1+Tanh((2/π)∗(x+0.044715∗x3)))

图

代码

import torch

import torch.nn as nnm = nn.GELU()

input = torch.randn(4)

output = m(input)print("input: ", input) # input: tensor([-1.2732, -0.4936, -0.8219, 0.1772])

print("output: ", output) # output: tensor([-0.1292, -0.1534, -0.1690, 0.1010])

【参考】

GELU — PyTorch 1.13 documentation

上一篇:考研复试——C、C++

下一篇:PMP第十二章重要知识点

相关内容

热门资讯

“75亿元投资理财”,摩尔线程...

澎湃新闻记者 周玲 日前,摩尔线程拟将IPO募集的资金不超过75亿元用于投资理财引发了广泛的关注。有...

2025年丰收背后的艰辛历程

2025年的丰收并非一帆风顺,农民们经历了极大的挑战和困难。受气候变化、自然灾害及市场波动等多重因素...

原创 印...

各位朋友大家好,欢迎来到今天的深度国际观察。最近大家都在盯着美联储,觉得只要美国那边一降息,黄金就得...

新修订《证券法》出台,会有更多...

证券法出台,企业上市注册制,对散户来说虽然二级市场会越来越好,风险会越来越大,今天聊聊退市问题,你就...

光大理财副总经理李永锋:以多资...

12月12日,光大理财副总经理李永锋在“时代新叙事 财富新未来”2025上证·大虹桥金融高质量发展大...